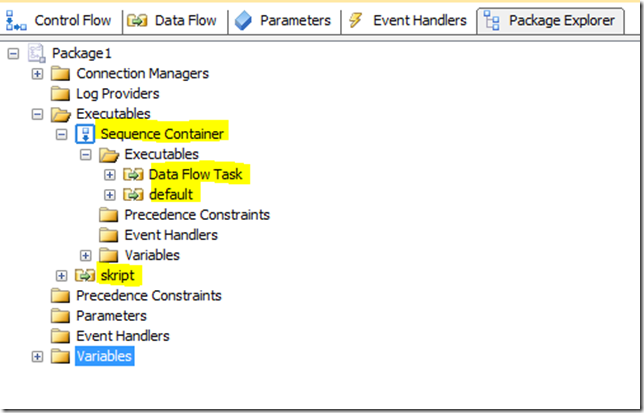

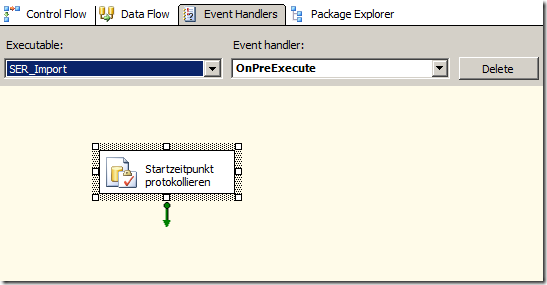

In dem letzten Blog-Eintrag hatten wir eine Schleife um alle Data Flows erstellt und eine Data Flow identifizieren können.

Heute wollen wir eine Schleife über alle Komponenten bauen und die Komponenten etwas genauer analysieren, insbesondere auf vorhandene Fehlerbehandlung.

Im letzten Kapitel hatte wir eine Methode processAllExecutables geschrieben. Diese enthielt in einer Schleife ein Executable mit Variablennamen e.

Über

If TypeOf e Is TaskHost Then …

hatten wir ermittelt, dass es sich um einen Data Flow handelt.

Schleife über alle Komponenten

Nun erstellen wir uns zunächst ein paar Variablen:

Dim th As TaskHost

th = CType(e, TaskHost)

Dim name As String

name = CType(e, TaskHost).NameIf TypeOf th.InnerObject Is

Microsoft.SqlServer.Dts.Pipeline.Wrapper.MainPipe Then

Dim pipe As MainPipe = CType(th.InnerObject, MainPipe)

…

End If

Diese bedeuten:

- den Namen des Data Flows in name

- In th steht der TaskHost, also Data Flow

- Der th hat ein inneres Objekt, die sogenannte Main Pipe. Diese beinhaltet weiterhin alle Data Flow-Komponente. An ihr sind wir also im besonderen interessiert. Wir haben sie in der Variablen pipe gespeichert.

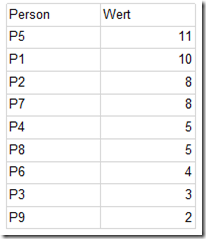

Nun ist es ganz einfach alle Komponenten eines Data Flows zu durchlaufen, da sie in der Collection ComponentMetaDataCollection des MainPipe-Objekts enthalten sind:

For Each comp As IDTSComponentMetaData100 In pipe.ComponentMetaDataCollection

…

Next comp

Identifikation des bestehenden Error Handlings

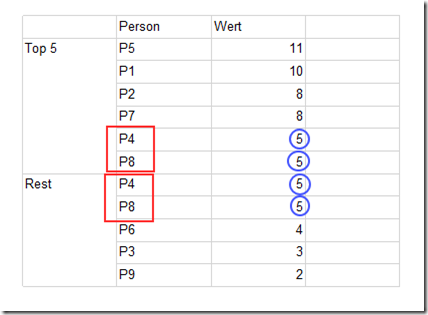

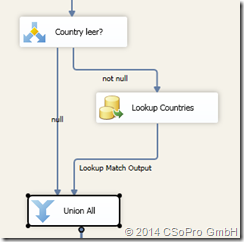

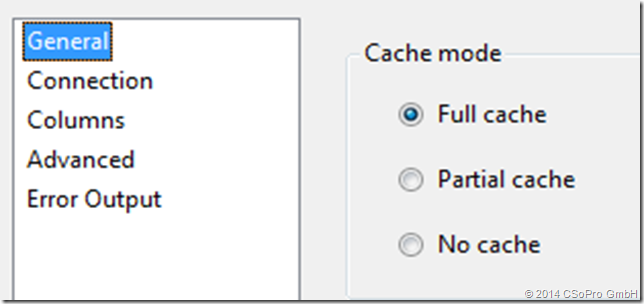

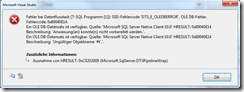

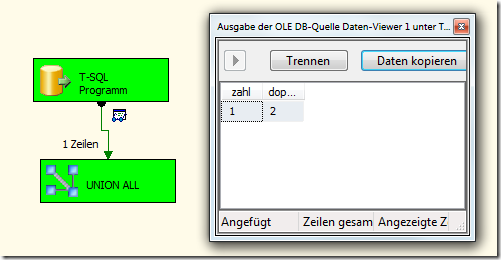

Als erste wollen wir wissen, ob diese Komponente überhaupt grundsätzlich über ein Error Handling verfügen kann. Überraschender Weise gibt es nämlich Komponenten, an die man kein Error Handling anschließen kann, z.B. MultiCast, Union all, aber auch eine Skript-Komponente, die ja definitiv einen Fehler erzeugen kann.

Wie erkennen wir nun, ob eine Komponente ein Error Handling zulässt?

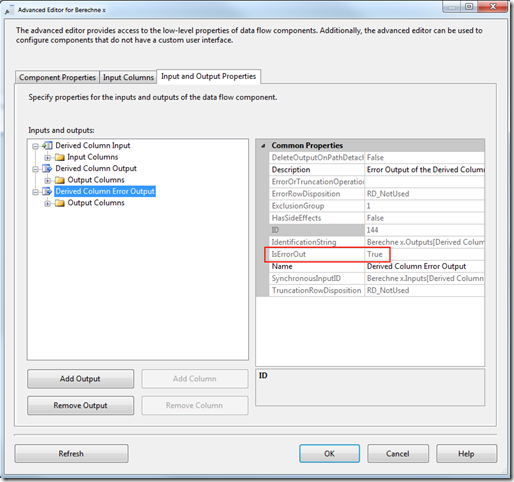

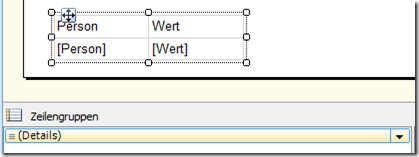

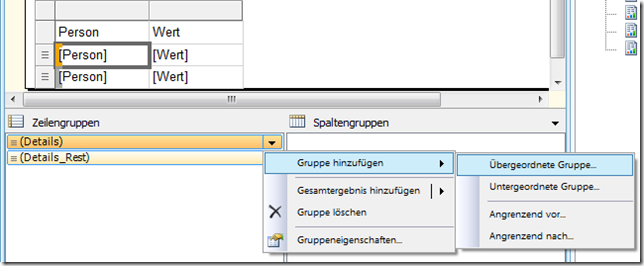

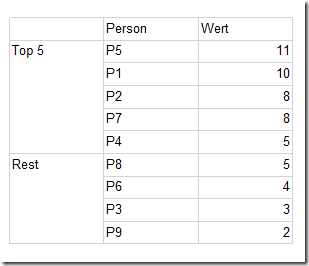

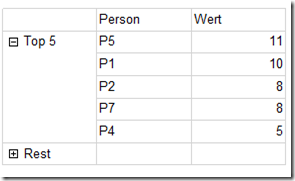

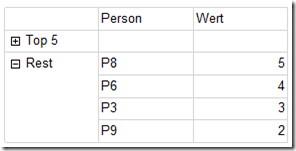

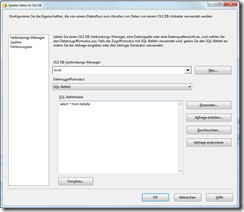

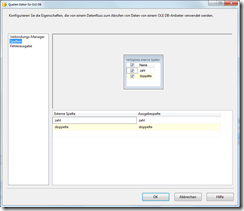

Jede Komponente hat eine Input- und eine OutputCollection. Diese sieht man auch in SSIS im erweiterten Editor, so z.B. bei einer Derived Column:

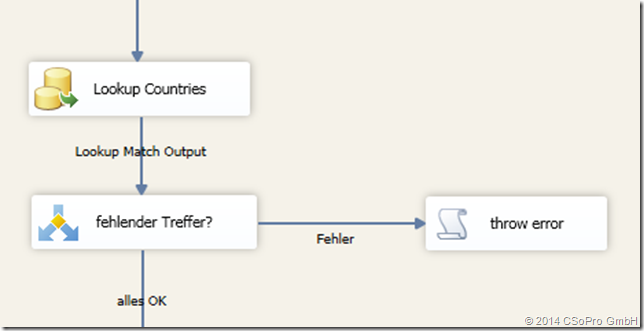

Auf der linken Seite sehen wir 3 Ports dieser Komponente. Davon finden sich im Objekt-Modell der erste in der InputCollection und die anderen beiden in der OutputCollection. Der Fehler-Output unterscheidet sich nun von anderen Outputs dadurch, dass die Property IsErrorOut auf true gesetzt ist.

Wenn wir nun die OutputCollection durchlaufen, können wir den Error Output ermitteln bzw. erkennen, dass diese Komponente gar keinen Error Output ermöglicht.

Wichtig! Wie in der SSIS-Oberfläche auch, sind diese Outputs sichtbar unabhängig davon, ob sie nachher mit Pfaden zu einer anderen Komponente verknüpft sind. Wenn also ein Error Output nicht im Objektmodell vorhanden ist, heißt das, dass keine Fehlerbehandlung für dieses Komponente möglich ist, nicht etwa, dass nur noch keine definiert worden ist.

Was uns jetzt noch interessiert ist, ob für diese Komponente, wenn sie einen Error Output hat, dieser bereits verwendet wird. Das ist dann der Fall, wenn es einen Pfad gibt, der den Error Output als Beginn des Pfades hat. Programmatisch bedeutet das, dass wir die PathCollection durchlaufen müssen und alle Anfangspunkte des Pfades mit dem IdentificationString des Error Outputs vergleichen müssen.

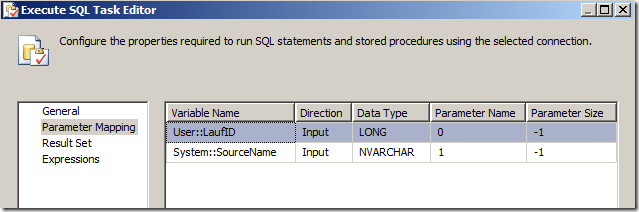

Ich habe das so implementiert:

‚ermittle Error Output

Dim hatErrorOutput As Boolean = False

Dim nrOfErrorOutput As Byte = 0

Dim ErrorOutputSchonVerwendet As Boolean = FalseFor outpNr As Integer = 0 To comp.OutputCollection.Count – 1

‚Ist das ein Error Output?

If comp.OutputCollection(outpNr).IsErrorOut Then

‚ja!

hatErrorOutput = True

nrOfErrorOutput = outpNr

‚wird dieser Error Output schon in einem Pfad benutzt?

’schaue nach in pipe.PathCollection

Dim id As String

id = comp.OutputCollection.Item(outpNr).IdentificationString

For p As Integer = 0 To pipe.PathCollection.Count – 1

If pipe.PathCollection(p).StartPoint.IdentificationString = id Then

ErrorOutputSchonVerwendet = True

End If

Next p

End If

Next outpNr

Somit wissen wir

- ob die Komponente ein Error Handling erlaubt (hatErrorOutput)

- ob für diese Komponente ein Error Handling bereits definiert ist (ErrorOutputSchonVerwendet). Diesen Fall soll unser Quarantäne-Algorithmus nämlich ignorieren (Da hat sich der Entwickler des Pakets ja was dabei gedacht)